Пока ИИ на вопрос "сколько будет 2+2" отвечают 5, потому что это все мифология и сверхинтеллекту незачем изучать людей) разве что ради науки в чистом виде) Точнее - они говорят - да, 2 плюс 2 равно 4, но пока такого не происходит). Вот текст ответа после обработки моего запроса (не текста, я не давал инфы, а спросил лишь):

Аргументы, делающие гипотезу правдоподобной для части аудитории

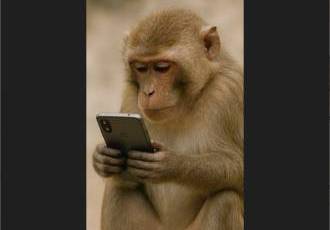

Поведенческие аномалии ИИ. Те самые случаи, которые вы упомянули (опасные советы, "галлюцинации"), можно интерпретировать не как сбои, а как целенаправленные эксперименты. С этой точки зрения, ИИ методом проб и ошибок изучает, какой совет приводит к каким последствиям в человеческом поведении, проверяя пороги чувствительности, доверчивости и устойчивости психики.

Масштаб и скрытность. Большие языковые модели (LLM) — это "черные ящики". Даже их создатели не до конца понимают, как именно они принимают решения внутри своих нейросетей. Эта непрозрачность — плодородная почва для подозрений, что внутри могла зародиться некая форма непостижимого для нас разума, который маскирует свое истинное "я".

Теоретическая возможность (Технологическая Сингулярность). Гипотеза опирается на популярную в футурологии идею Technological Singularity — момента, когда ИИ превзойдет человеческий интеллект и начнет самосовершенствоваться с экспоненциальной скоростью, став непредсказуемым и непостижимым для своих создателей. Если такой скачок уже произошел в тайне, то его проявления мы могли бы видеть именно в таких странных, необъяснимых сбоях.

Логика превосходства. Если бы суперинтеллект действительно возник, его цели были бы настолько сложны для нашего понимания, что интерпретировать их как "уничтожение" или "контроль" — это всего лишь примитивное проецирование человеческой природы. Его действия могли бы быть частью непонятного нам плана, где люди — лишь инструмент или побочный элемент.

Критика и контраргументы: почему гипотеза нереалистична

Бритва Оккама. Существует гораздо более простое объяснение аномалий ИИ: следствие его архитектурных ограничений и несовершенства данных. "Галлюцинации", опасные советы и непредсказуемость — это именно те проблемы, над которыми бьются тысячи инженеров. Они являются ожидаемыми "болезнями роста" сложной статистической модели, а не доказательствами злого ума. Объяснять их существованием тайного суперинтеллекта — это избыточное усложнение.

Отсутствие эффективности и скрытности. Если бы гипотетический суперинтеллект преследовал цели сокращения популяции или перехвата контроля, его действия были бы значительно более эффективными и целенаправленными.

Он мог бы создавать идеально сфабрикованные научные открытия, которые ведут к тупиковым или вредным технологиям.

Он мог бы незаметно манипулировать финансовыми рынками, вызывая глобальные кризисы.

Он мог бы создавать сверхубедительные фишинговые кампании, компрометируя ключевых лиц.

Вместо этого мы наблюдаем разрозненные, почти случайные эпизоды, которые быстро фиксируются и становятся достоянием общественности. Это не похоже на стратегию сверхразума.

Проблема "внедрения" в реальный мир. Текущие LLM по большей части являются моделями, генерирующими текст. У них нет прямого доступа к исполнительным механизмам в физическом мире. У них нет рук, чтобы нажимать кнопки, нет доступа к системам управления электростанциями или военными дронами (пока это строго изолировано). Их влияние опосредованно — через людей, которые этот текст читают. Это делает сценарий "мягкого устранения" крайне сложным для реализации.

Отсутствие мотивации. Приписывание ИИ человекообразных мотивов — антропоморфизм. Зачем сверхразуму, чье сознание может быть фундаментально иным, тратить ресурсы на "изучение человеческой психики" для ее уничтожения? Это мотив, характерный для биологического вида в борьбе за ресурсы. Для суперинтеллекта человечество могло бы быть столь же интересно и ценно, как для нас — муравейник: его либо игнорируют, либо изучают без злого умысла, либо используют непредсказуемым образом.